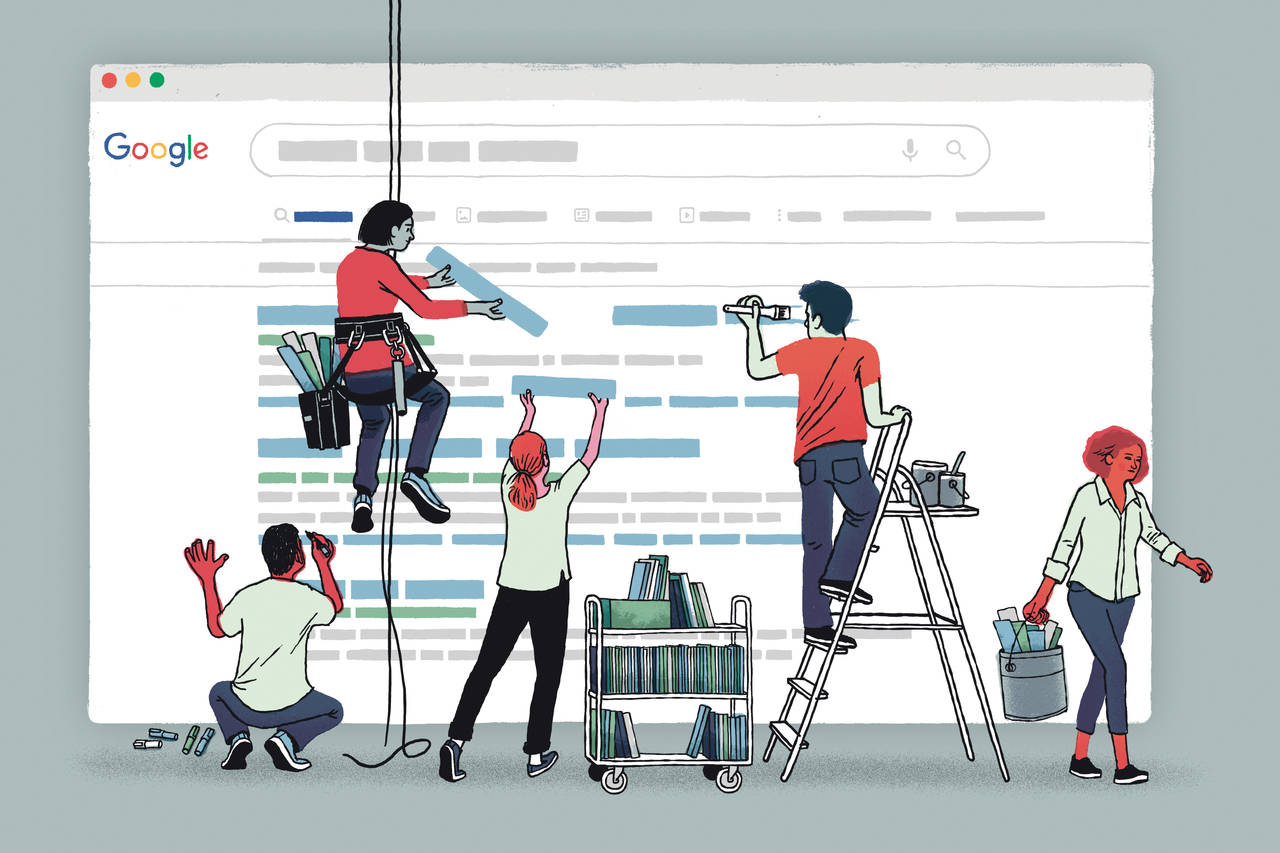

Le système de protection et de sanctions de Google

Depuis que les moteurs de recherche existent, les spécialistes du référencement ont tenté de rendre plus pertinents les sites qu’ils référençaient pour passer devant les sites concurrents et prendre la tête des résultats de recherche.

Le Web spam (spamdexing, search spam)

Cela passe pas, notamment, par une adaptation de la structure du site, du code et du contenu de chaque page ainsi que par la multiplication des liens qui pointent vers ce dernier. Certains référenceurs sont très efficaces et parviennent à manipuler à leur avantage les moteurs de recherche, d’autres sont moins efficaces, certains respectent les consignes des moteurs de recherche, d’autres ne les prennent pas du tout en compte, perturbant plus ou moins gravement le fonctionnement de ces derniers. On parle alors de webspam, de spamdexing ou de manipulation abusive des résultats des moteurs de recherche.

Les moteurs de recherche ont, donc, toujours du lutté, plus ou moins activement, afin de protéger l’intégrité de leurs pages de résultats et continuer à délivrer des résultats pertinents. Les enjeux spamdexing sont suffisamment importants pour que Google ait créé un service dédié à la lutte contre ce qu’il assimile à une fraude contre les règles qu’il a édictés. Ce service nommé le Web Spam Team au sein du groupe contrôlant la qualité des résultats de recherche de Google ou « Search quality group ».

Le modus operandi de ce groupe, la définition exacte du « Web spam », le système de détection et de sanction de la fraude sont mal connus de la plupart des référenceurs.

Mais, empiriquement, l’auteur de l’étude a mis en évidence que Google semblaient classer les référenceurs en 4 catégories qu’il traite, de façon différenciée.

Les 4 familles de référenceurs

L’auteur de cette étude classe les référenceurs en 4 catégories en fonction de leurs pratiques.

1°) Les maladroits

Ils connaissent mal l’algorithme de classement de Google et utilisent des techniques complètement inefficaces, soit parce qu’elles s’appuient sur une analyse éculée du fonctionnement de Google, soit parce qu’ils sous estiment la complexité de ce moteur de recherche.

Ils ne sont pas capables de mettre en place de dispositifs complexes susceptibles de manipuler le système de classement de Google, qui détecte leur tentatives via des filtres automatiques et les neutralisent.

2°) Les White hats

Ces « chapeaux blancs » du référencement sont des référenceurs qui se conforment strictement aux consignes officielles de Google aux webmasters (Google webmaster guidelines). Insertion de contenus pertinents dans les balises title, H1, H2…, dans les meta tags…Ils adaptent légèrement le contenu et la structure de leurs sites. Cela permet, un peu, à ces référenceurs d’augmenter la visibilité de leur site dans les moteurs de recherche, sur des mots clés peu concurrencés et peu demandés par les internautes, mais sur les mots clés les plus concurrencés, ces référenceurs sont dépassés. Il est à noter que de nombreux référenceurs se réclamant White hats, ne respectent pas rigoureusement les consignes de Google puisqu’ils sollicitent des liens non légitimes d’autres sites, uniquement dans le but de manipuler l’algorithme de Google à leur avantage. Ces derniers obtiennent de meilleurs résultats que les pures « White Hats ».

La brigade anti spam de Google, à travers les conseils de son responsable, Matt Cutts, encouragent le maximum de webmasters à se convertir en réels White hats, mais n’avantage pas ces derniers.

3°) Les Black hats

A l’inverse des « white hats », les « black hats » ou chapeaux noirs sont des référenceurs qui font ce qu’il faut pour obtenir des résultats et sont prêts à enfreindre lourdement et les consignes de Google. Ils recourent à toutes les techniques de manipulation des pages de résultats de recherche y compris lorsque cela implique de présenter une version d’une page donnée aux internautes ordinaires et une version totalement différente aux robots indexeurs de Google lorsqu’ils viennent visiter le site, afin de gagner en pertinence (en répétant de très nombreuses fois le mot clé sur la page, par exemple). Cette technique est dénommée « cloaking ». Les black hats peuvent aussi aller jusqu’à créer des centaines de faux blogs afin de multiplier les faux liens pointant vers un site.

Les Black Hats qui opèrent souvent dans le domaine du crédit, de l’assurance, du X, des jeux en lignes ou de la distribution de produits comme le Viagra, peuvent être amenés à référencer des sites ordinaires.

Les Black Hats sont la cible principale de la Web Spam Team et mobilise une grande partie de ses efforts.

4°) Les Grey hats

Entre les White hats à la technique à l’efficacité limitée et les Blacks hats pourchassés par Google, la plupart des référenceurs sont des Grey hats, qui tentent de ne pas trop dépasser la « ligne jaune » entre le « bien » (consignes de Google) et le mal (les techniques de manipulations très lourdes).

De nombreux Grey hats se réclament White hats estimant que les petites infractions qu’ils s’autorisent, ne font pas d’eux des référenceurs malhonnêtes.

Google essaie de lutter contre les agissements de grey hats lorsque ces derniers manquent de finesse dans le déploiement de leurs techniques «non autorisées ».

Jusqu’en 2004, la quasi-totalité des bons référenceurs étaient des Black Hats, parce que, pour passer devant les sites bien référencés, qui recouraient à des techniques non autorisées, il fallait aussi utiliser des techniques non autorisées. Les moteurs de recherche déconseillant certaines pratiques depuis 1995, mais ne le sanctionnant pas leur usage par un déclassement systématique, la plupart des bons référenceurs ignoraient les recommandations de Google.

La milice de Google

Fin 2003, Google décida de faire disparaître purement et simplement les sites contrevenants de son index.

Certains sites disparurent totalement des pages de résultats de Google et vire leur trafic chuté de 30%, 50% et parfois même de 90% pour ceux qui reposaient essentiellement sur Google. Cette vague de sanction atteignit les États Unis en novembre 2003 et arriva en France et en Europe, à partir de février 2004 avec un point culminant en septembre 2004.

Les sites des agences de référencement furent touchés en priorité et furent suivis des sites ordinaires qui contrevenaient, de façon trop ostensible aux règles de Google: tous les sites de BMW en Europe disparurent durant plusieurs semaines de Google, de même que celui du célèbre portail américain Business.com.

A cette époque, les techniques consistaient à cacher du texte ou des liens dans des parties invisibles d’une page ou à créer des pages totalement artificielles destinées à n’être vues que des moteurs de recherche et redirigeant les internautes vers les véritables pages du site (on parlait alors de « pages satellites » ou de « doorway pages »).

En l’espace de quelques mois, la communauté des référenceurs modifia totalement ses pratiques, contraintes et forcée par la création, chez Google, d’une équipe en charge de neutraliser les référenceurs Black hats: la Web Spam Team. La Web Spam Team a mise en place un système qui s’est perfectionné avec le temps et qui, aujourd’hui s’appuie sur six piliers:

- Des programmes de détection automatiques des techniques les plus facilement détectables, qui peuvent aller à la détection de répétitions anormales d’un même mot clé sur une page, à l’analyse du type de liens pointant vers une même page,

- Un système de dénonciation en ligne des sites recourant à des méthodes non autorisées, les « Spam Reports », Un système de contrôle humain des sites apparaissant sur les requêtes les plus convoitées par des « Quality managers Une analyse manuelle, par les «inspecteurs » de la Web Spam Team, des sites présumés contrevenants

- Un éventail de sanction pouvant aller jusqu’à la disparition totale du site de l’index de Google (on dit alors que le site a été « black listé »

La possibilité de demander une ré-inclusion pour les sites sanctionnés ayant modifiés leurs pratiques. En marge de ces actions de lutte contre le Web Spam, Google a également mis en place en 2009, un système de signalement des sites forçant le téléchargement automatique de logiciels espions ou de virus, qui ne visent pas les référenceurs Black Hats, mais les pirates souhaitant diffuser des virus ou de la publicité contre la volonté des internautes.